Entropi (informationsteori)

Från Rilpedia

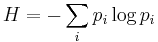

Entropi definierades som ett begrepp inom informationsteorin av Claude Shannon 1948 för en informationskälla som genererar symboler. Baserat på sannolikheten för varje symbol definieras entropin över hela sannolikhetsfördelningen som:

Begreppet definierades utifrån behovet att beräkna kapaciteten hos kommunikationskanaler, och grundar sig på stokastiska sannolikheter.

Definitionen är skapad som en analogi till den mikroskopiska definitionen av den termodynamiska storheten entropi.