Information (mått)

Från Rilpedia

| Det har föreslagits att denna artikel bör slås ihop med informationsteori. (Diskutera) |

| Den här artikeln saknar källhänvisningar. Förbättra gärna artikeln genom att lägga till pålitliga källor (helst fotnoter). Material som inte kan verifieras kan ifrågasättas eller tas bort. (juni 2009) |

Informationsteori

I informationsteoretisk mening är information ett mått på den ökade bestämningsgrad man erhåller då ett mängd möjliga alternativ reduceras till ett mindre mängd alternativ. Denna mäts som logaritmen av kvoten mellan antalet alternativ före och efter reduktionen:

- log (antal alternativ före / antal alternativ efter)

eller, vilket är detsamma:

- log (antal alternativ före) - log (antal alternativ efter)

Om logaritmen har basen 2 anges informationen i bitar som motsvarar det antal binära val som behövs för att reducera mängden alternativ till ett alternativ. Detta mått kan även ange delar av bitar (vid beräkning av genomsnitt) trots att det är svårt att föreställa sig delar av ett binärt val. En bit erhålls för varje gång antalet återstående alternativ reduceras till hälften. Reduktionen av antalet alternativ utgör en informativ process som kan följa olika strategier. När endast ett alternativ återstår har detta blivit utpekat och ingen mer information kan erhållas.

Detta informationsmått används bl.a. inom kommunikationsteori för att beräkna en kanals kapacitet att överföra information och inom kodningsteori för att beräkna redundans och graden av möjlig datakomprimering.

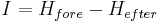

Generellt utgör erhållen information en skillnad i Entropi osäkerhet före och efter händelsen som gett information:

Ömsesidig information

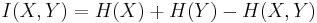

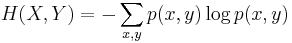

Baserad på Claude Shannons entropibegrepp har en teori för ömsesidig information utvecklats. Två händelser X and Y ger varandra ömsesidig information I(X, Y) enligt:

där