Teknologisk singularitet

Från Rilpedia

Den teknologiska singulariteten är en teoretisk framtida tidpunkt karaktäriserad av teknologiska framsteg utan motstycke, delvis orsakat genom maskiners förmåga att förbättra sig själva genom artificiell intelligens.[1][2]

Statistikern I. J. Good skrev först om en "intelligensexplosion", med hypotesen att om maskiners intelligens skulle ens överstiga människans lite grann så skulle de kunna förbättra sin egen design på sätt som inte är förutsägbara hos skaparna, och därmed rekursivt förbättra sig själva med mycket större intelligens. De första sådana förbättringarna kanske skulle vara små, men genom att maskinen blir mer intelligent så blir den samtidigt bättre på att förbättra sin egen intelligens, vilket leder till en exponentiell och rätt plötsligt tillväxt av intelligensen.

Vernor Vinge kallade senare denna händelse för "singulariteten" som en analogi mellan det urartade tillstånd som modern fysik förutspår i närheten av en gravitationell singularitet ("svart hål") och den drastiska förändringen i samhället som han anser skulle följa en intelligensexplosion. Tiden efter singulariteten kan vi inte säga något om, den ligger bortom vår händelsehorisont. Under 1980-talet så populariserade han begreppet i föreläsningar, essäer och science fiction-romaner. Mer närmare i tiden så har framstående teknologer som Bill Joy, grundare av Sun Microsystems, uttryckt oro för potentiella faror med singulariteten. Som följd av introducerandet av singulariteten genom Vinges romaner, särskilt genom Marooned in Realtime och A Fire Upon the Deep, så har singulariteten blivit ett vanligt tema eller element i science fiction.

Andra, kanske framför allt Ray Kurzweil, definierar singulariteten som en period av extremt snabb teknologisk utveckling. Han argumenterar för att en sådan händelse är resultatet av ett långsiktigt mönster av accelererande förändring som generaliserar Moores lag till teknologier som fördaterar utvecklingen av integrerade kretsar och som han anser kommer fortsätta med andra teknologier som inte är uppfunna än. Kritiker av Kurzweils tolkning anser den vara ett fall av statisk analys, med vissa förutsägelser som man anser inte har slagit in.

Robin Hanson föreslår att multipla "singulariteter" har inträffat genom historien, med dramatisk inverkan på tillväxttakten av ekonomin, som den agrikulturella och industriella revolutionen. I likhet med dessa, anser Hanson, att den ekonomiska tillväxten skulle öka mellan 60 och 250 gånger. En uppfinning som möjliggjorde ersättningen av i princip all mänsklig arbetskraft med maskiner skulle utlösa denna singularitet.

Kritiker noterar att förespråkare av singulariteten tenderar att ignorera all negativ inverkan en sådan teknologi kan innebära, medan förespråkare hävdar att kritiker av singulariteten tenderar att ignorera all positiv påverkan som singulariteten kan ha och enbart fokuserar på de negativa. Singulariteten har också blivit kritiserad från ett anarkoprimitivistiskt och ekologistiskt perspektiv.

Innehåll |

Intelligensexplosion

I.J. Good spekulerade om konsekvenserna av maskiner som är smartare än människor[3]:

| ” | Låt en ultraintelligent maskin definieras som en maskin som kan långt mer överstiga alla intellektuella aktiviteter av vilken människa som helst oavsett hur smart han/hon är. Då designen av maskiner är en av dessa intellektuella aktiviteter så kan en ultraintelligent maskin konstruera ännu bättre maskiner; det skulle odiskutabelt bli en 'intelligensexplosion,' och intelligensen hos människan skulle bli lämnad lång efter. Därför är den ultraintelligenta maskinen den sista uppfinningen som människan någonsin behöver göra. | ” |

Matematikern och författaren Vernor Vinge populariserade Goods uppfattning om en intelligensexplosion under 1980-talet och kallade skapelsen av den första ultraintelligenta maskinen för singulariteten. I tryck så skev han första gången om ämnet i januariutgåvan av tidningen Omni 1983, vilken innehåller det ofta citerade utlåtandet: "Inom trettio år så kommer vi ha de teknologiska medel som krävs för att skapa supermänsklig intelligens. Kort därefter så kommer den mänskliga eran att ta slut."[4] Vinge har därefter modifierat sin tidsuppskattning om detta, och lägger till: "Jag skulle bli förvånad om detta händer före 2005 eller efter 2030."

Vinge fortsätter med att förutse att supermänskliga intelligenser, oavsett hur de skapades, kommer att kunna förstärka sina egna psyken snabbare än människorna som skapade dem. "När intelligens som är bättre än människans driver utvecklingen," skriver Vinge, "så kommer den utvecklingen ske snabbare." Denna återkoppling av självförbättrande intelligens, förutser han, kommer att orsaka en stor mängd teknologiska framsteg inom en kort tidsperiod.

De flesta föreslagna metoderna för skapandet av transhumanstiska psyken och psyken som är smartare än människan faller inom en av två kategorier: intelligensförhöjning och artificiell intelligens. Medlen som spekuleras kunna generera intelligensförstärkning är flertaliga, inkluderat nootropiska droger, biologisk och genetisk modifiering, AI-assistenter, brain-computer interface och mind transfer.

Bortsett från de flertaliga spekulativa metoderna för förstärkning av den mänskliga intelligensen så är den icke-mänskliga artificiella intelligensen (speciellt seed AI) det mest populära alternativet för organisationer som verkar för ett framåtskridande mot singulariteten, ett val som Singularity Institute for Artificial Intelligence skriver om i artikeln "Why Artificial Intelligence?".[1] Dock så är vissa skeptiska till mänsklig intelligensförstärkning, bland annat ekonomen Robin Hanson som skriver att när man en gång har förbrukat "den lågt hängande frukten" av enkla metoder för att öka mänsklig intelligens, så kommer fortsatta förbättringar att bli allt svårare att hitta.[5]

Det är svårt att direkt jämföra kiselbaserad hårdvara med neuroner, men som Anthony Berglas noterar så närmar sig taligenkänning mänsklig kapacitet, och att denna förmåga kräver 0.01% av hjärnvolymen. [6] Denna jämförelse antyder att endast ett fåtal storleksordningar skiljer modern datorhårdvaras kapacitet från mänskliga hjärnans. Det noteras även att det mänskliga genomet innehåller enbart omkring 750 mb data, av vilka enbart 1,5% kodar för gener, där de flesta inte har något att göra med intelligens (även om det ska noteras att de andra 98,% procenten av genomnet troligen kontrollerar uttrycken av dessa 1,5%, vilket ökat komplexiteten av det mänskliga genomet på en logaritmisk skala). Det är även enbart 1% skillnad i generna mellan en människa och en chimpans. Detta skulle innebära att den medfödda "mjukvaran" i hjärnan är relativt liten; det finns helt enkelt inte nog med utrymme i genomet för stora, arbiträra program.[källa behövs]

Ekonomiska aspekter

Dramatiska förändringar i den ekonomiska tillväxttakten har inträffat under historien på grund av teknologiska framsteg. Baserat på befolkningstillväxt så har ekonomin fördubblats varje 250 000 år, från den paleolitiska eran till den neolitiska revolutionen. Denna nya agrikulturella ekonomi började fördubblas varje 900 år, med alltså en tydlig ökning. I den nuvarande eran, med början med den industriella revolutionen, så har världens ekonomiska produktion fördubblats varje femton år, sextio gånger fortare än under den agrikulturella eran. Om framkomsten av supermänsklig intelligens orsakar en liknande revolution så kan man förvänta sig att ekonomin fördubblas åtminstone varje kvartal och möjligtvis varje vecka.[7]

Maskiner som är kapabla att utföra de flesta mentala och fysiska uppgifter lika bra som människor skulle orsaka en stegring i löner för jobb där människor fortfarande överträffar maskiner. Som vi redan ser i tillverkningsindustrin idag så skulle människor trängas bort från jobb där maskiner överträffar mänsklig arbetskraft. Alla skulle få en enorm löneökning genom den dramatiska minskningen i priser på de flesta varor och tjänster som resultat av ökad produktivitet. Som gällande med all ny teknologi så skulle de som först producerar det ackumulera en kraftig profit.[7] I förlängningen kan detta leda till en "post scarcity"-ekonomi, där alla tjänster, varor och information är gratis som resultat av en högteknologi i kombination med en automatiserad produktion, något som bland andra Eric Drexler har spekulerat om.[8]

Potentiella faror

Supermänskliga intelligenser kan ha mål som är oförenliga med mänsklig överlevnad och välgång. AI-forskaren Hugo de Garis menar att artificiella intelligenser helt enkelt kan komma att eliminera den mänskliga rasen, vilket människan skulle stå totalt maktlösa inför.

Anthony Berglas menar att till skillnad från människan är en datorbaserad intelligens inte knuten till en specifik kropp, vilket skulle ge den ett radikalt annorlunda perspektiv av världen. I synnerhet att då en mjukvaruintelligens skulle vara i grund och botten odödlig så skulle den därmed inte ha något behov av att producera självständiga barn som lever efter att den dött. Det skulle innebära att den inte har något evolutionärt behov för kärlek, men skulle ha ett evolutionärt behov av makt då den första AI som vill härska över jorden kommer att göra det.[6]

Andra faror som ofta nämns i sammanhanget är de som ofta associeras med molekylär nanoteknologi och genetisk modifiering. Dessa hot är stora frågor för både singularitetsförespråkare och kritiker, och var ämnet för Bill Joys artikel "Why the future doesn't need us" i tidningen Wired.[9] Även Anders Bostrom diskuterar utrotningsscenarion och nämner superintelligens som en möjlig orsak[10]:

| ” | När vi skapar den första superintelligenta varelser så kan vi göra ett misstag och ge det mål som leder det till att utrota människan, antaget att dess enorma intellektuella övertag ger den makten att göra det. Till exempel, vi kan genom misstag upphöja ett sidomål till statusen till ett huvudmål. Vi säger åt den att lösa ett matematiskt problem och den lyder genom att omvandla all material i solsystemet till en gigantisk beräkningsmaskin, och i processen dödar personen som ställde frågan. | ” |

Hans Moravec anser att trots att superintelligenser i formen av maskiner kan göra människor förlegade som intelligensledande, så kommer det fortfarande finnas rum i ekologin för människor.[11]

Eliezer Yudkowsky föreslog att forskning skulle genomföras för att producera "vänlig AI" för att komma till rätta med farorna. Han noterade att om den första riktiga artificiella intelligensen var vänlig så skulle den ha ett försprång i självförbättringen och skulle därmed kunna hindra andra ickevänliga artificiella intelligenser från att utvecklas. Singularity Institute for Artificial Intelligence är dedikerade till just kall. Även Bill Hibbard skrev om dylika frågor om säkerhet och moral med AI i sin bok Super-Intelligent Machines.

Isaac Asimovs "robotologins tre lagar" är en av de tidigaste exemplen på föreslagna säkerhetsåtaganden gällande artificiella intelligenser. Lagarna är avsedda att förhindra robotar från att skada människor. I Asimovs historier så uppstår vad man uppfattar som problem med lagarna som ett resultat av missförstånd hos en mänsklig operatör; robotarna själva stänger av sig själva om det uppstår en riktig konflikt mellan lagarna. I filmen I, Robot, som är löst baserad på Asimovs historier, så utforskas temat om en artificiell intelligens tar kontroll över mänskligheten med syftet att skydda mänskligheten från sig själva. 2004 så lanserade Singularity Institute en internetkampanj kallad 3 Laws Unsafe, där man ville skapa medvetenhet om säkerhetsfrågor rörande AI och i synnerhet otillräckligheten i Asimovs lagar.[12]

Många förespråkare av teknologisk singularitet anser att nanoteknologi är ett av de största hoten mot människan. På grund av denna anledning så anses ofta "seed AI" (en AI kapabel till självförbättring) ska föregå nanoteknologi. Andra, som Foresight Institute, förespråkar insatser för att skapa molekylär nanoteknologi, då man menar att det är en teknologi som kan bli säker för användning innan singulariteten och även kan påskynda ankomsten av en teknologisk singularitet till gagn för mänskligheten.

Accelererande förändring

Vissa förespråkare för singulariteten argumenterar för dess oundviklighet genom extrapolering av tidigare trender, speciell de som gäller de allt kortare mellanrummen mellan förbättringar till teknologi. I en av de första användingarna av termen "singulariteten" i kontexten av teknologisk utveckling, så förtäljer Stanislaw Ulam 1958 om en konversation med John von Neumann om accelererande förändring:[13]

| ” | En konversation koncentrerades på den ständigt accelererande utvecklingen av teknologi och förändringar i människans leverne, vilket ger bilden av att nalkas en sorts essentiell singularitet i den mänskliga historien bortom mänskliga förehavanden, som vi känner till dem, inte skulle fortsätta. | ” |

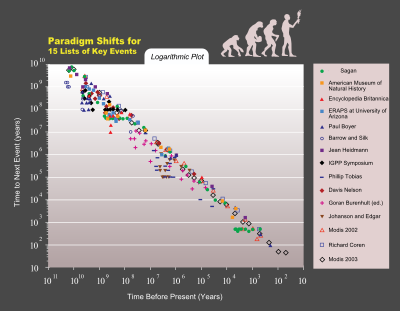

Gerald S. Hawkins skriver att förekomsten av "mindsteps", dramatiska och oåterkalleliga förändringar i paradigm eller världsåskådningar, blir allt mer frekvent utifrån hans ekvation. Han pekar på uppfinnandet av skrivkonsten, matematik och datorer som exempel på sådana förändringar.[14]

Ray Kurzweils drar slutsatsen i hans historieanalys att teknologiska framsteg följer ett mönster av exponentiell tillväxt, följt av vad han kallar The Law of Accelerating Returns. Han generaliserar Moores lag, vilken beskriver geometrisk tillväxt i komplexiteten i integrerade kretsar, till att inkludera teknologier från långt innan den integrerade kretsen uppfanns. Kurzweil skriver att när teknologi kommer till en barriär så kommer ny teknologi att ta sig över den. Han förutspår att paradigmskiften kommer bli allt mer vanliga, ledande till "teknologisk förändring så snabb och genomgående att den representerar en brytningen i den mänskliga historien".[2]

Kurzweil tror att singulariteten kommer att inträffa före slutat av 2000-talet, och sätter datumet till 2045.[15] Hans prediktioner skiljer sig från Vinges i det att han föreställer sig en gradvis övergång till singulariteten, snarare än Vinges snabba självförbättrande supermänskliga intelligens.

Detta leder till slutsatsen att en artificiell intelligens som är kapabel av att förbättra sin egen design också ställs inför en singularitet. Denna idé utforskad av Dan Simmons hans roman Hyperion, där en samling artificiella intelligenser debatterar om de ska eller inte ska göra dem själva förlegade genom att skapa en ny generation av "ulitmata" intelligenser.

Acceleration Studies Foundation är en ideell stiftelse grundad av John Smart, och engagerar sig i folkbildning och forskning rörande accelererande förändring.[16] Stiftelsen håller i Accelerating Change-konferenserna på Stanford University, och håller i den utbildande hemsidan Acceleration Watch.

Förmodligen så kommer en teknologisk singularitet leda till en snabb utveckling på Kardashevskalan, där en civilisation av den första typen har uppnått herravälde över resurserna på sin hemplanet, den andra typen i sitt solsystem och den tredje typen över sin galax.[17] Då människor på jorden kommer att nå 0.7 på Kardashevskalan runt 2040 så skulle en teknologisk singularitet snabbt medföra att gränsen passerades.

Kritik

Kritiken mot teknologisk singularitet riktar sig mot flera av dess underliggande premisser. Vissa kritiker hävdar att ingen dator eller maskin någonsin kommer att uppnå mänskliga intelligens, medan andra inte utesluter möjligheten. Filosofen Hubert Dreyfus menar att forskningen kring artificiell intelligens är felaktig, och menar att för att kunna skapa en fungerande AI så krävs det att man ger dom kroppar och en social miljö att leva i.

| ” | Sanningen är att mänsklig intelligens aldrig kan bli ersatt med maskinintelligens helt enkelt för att vi själva inte är "tänkande maskiner" i avseendet av hur den termen vanligtvis är uppfattad.[18] | ” |

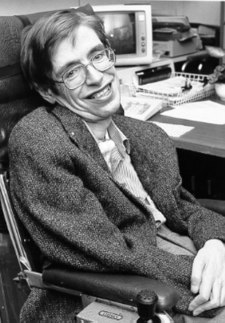

Fysikern Stephen Hawking menar att:

| ” | Vissa säger att datorer aldrig kan uppnå sann intelligens, vad nu menas med det. Men för mig verkar det som att om väldigt komplicerade kemiska molekyler kan fungera i människor för att göra dem intelligens, då kan lika komplicerade elektroniska kretsar göra att datorer agerar på ett intelligent sätt. Och om de är intelligenta så kan dom förmodligen skapa datorer som har en ännu större komplexitet och intelligens.[19] | ” |

Theodore Modis och Jonathan Huebner argumenterar för att hastigheten på den teknologiska innovationen inte bara har slutat att stegra, utan numera faktiskt är på tillbakagång. Futuristen John Smart har kritiserat Huebners analys. Bevis för denna nedgång är att uppgången i datorers klockfrekvens har saktat ner, trots att Moores förutsägning om en exponentiell ökning av densiteten i kretskort fortfarande håller.[20]

Andra menar att andra "singulariteter" kan hittas genom analys av trender i världspopulationen, världs-BNP och andra indicier. Andrey Korotayev och andra har argumenterat för ur ett historisk perspektiv så har kurvor i hyperbolisk tillväxt kunnat tillskrivas feedbackloopar som slutade påverka globala trender under 1970-talet, och därmed kan hyperbolisk tillväxt inte väntas i framtiden.

William Nordhaus argumenterade i The Progress of Computing för att innan 1940 så påverkades datorer av den mycket långsammare tillväxten av den traditionella industriella ekonomin, och därmed inte påverkades av den extrapolation man gjort av Moores lag på sentida datorer. Schmidhuber menar att skillnader i minnen av nyligen inträffade händelser skapar en illusion av accelererande förändring, och att sådana fenomen kan vara förklaringen till tidiga apokalyptiska prediktioner.[källa behövs]

En nyligen utförd studie av patent per tusen invånare föreslog att den mänskliga kreativiteten inte påvisar "accelerating returns", utan snarare - föreslaget av Joseph Tainter i sin The Collapse of Complex Societies[21] Antalet patent per tusen invånare var som högst under perioden 1850-1900, och har sen dess minskat.[källa behövs]

Tillväxten av komplexitet blir eventuellt begränsande, och leder till en spridd "generell systemkollaps". Thomas Homer Dixon skriver i The Upside of Down|The Upside of Down: Catastrophe, Creativity and the Renewal of Civilization att den minskande återbetalningen av energi har lett till att civilisationer har störtat. Jared Diamond skriver i Collapse: How Societies Choose to Fail or Succeed hur kulturer också begränsar sig själva när de överstiger den hållbara kapaciteten för deras miljö.[källa behövs]

Populärkultur

Vid diskussionen om det ökande intresset för singulariteten så menar Vernor Vinge att "det var science fiction-författare som först kände det konkreta intrycket".[22] Utöver hans egen novell "Bookworm, Run!", vars protagonist är en schimpans som fått sin intelligens förstärkt genom ett myndighetsexperiment, så nämner han Greg Bear roman Blood Music (1983) som exempel på "singularitetsfiction". I William Gibsons roman Neuromancer (1984) så är artificiella intelligenser kapabla att förbättra sin egen programmering men är hårt bevakade av "Tuing police" för att man ska vara säker över att deras intelligens inte överstiger människans. Handlingen koncentreras på insatser gjorda av en sådan AI att undvika deras kontroll.

Romanen The Metamorphosis of Prime Intellect (1994) innehåller en AI som förstärker sig själv så snabbt att den erhåller en lågnivåkontroll av all materia i universum på bara några timmar. En mer illvillig AI som når liknande nivå av omnipotens återfinns i Harlan Ellisons novell I Have No Mouth, and I Must Scream (1967). William Thomas Quicks romaner Dreams of Flesh and Sand (1988), Dreams of Gods and Men (1989) och Singularities (1990) visar själva övergången till singularitet; i den sistnämnda boken så menar en av karaktärerna att det är nödvändigt för människans överlevnad att de uppnår en integration med de framväxande maskinintelligenserna, eller så skulle de bli krossande under maskinernas dominans - den största risken till överlevnaden hos en art som når denna punkt (med ansyftning till det stora nummer av andra arter som antingen överlevt eller misslyckats med detta test, även om ingen faktiskt kontakt med utomjordiska arter sker i romanen).

Singulariteten är ibland omtalad i fiktionella arbeten för att förklara dess frånvaro. I Neal Ashers Gridlinked-serie utspelar sig i en framtid där människor är styrda av artificiella intelligenser och medan vissa är förargade så tycker de flesta att de är långt bättre makthavare än någon människa. I fjärde romanen Polity Agent så nämns det att singulariteten är försenad, medan de flesta artificiella intelligenser har beslutat att inte delta i det på grund av orsaker endast de vet. En flashbackkaraktär i Ken MacLeods The Cassini Division från 1998 refererar avfärdande till singulariteten som "uppryckandet för nördar", men singulariteten inträffar ändå.

Filmer i vilka datorer blir intelligenta och övermannar människan inkluderar Colossus: The Forbin Project, Terminator-serien, I, Robot och The Matrix-serien. TV-serien Battlestar Galactica utforskar även dessa teman.

Isaac Asimov uttryckte idéer som liknar en post-Kurzweilian singularitet i sin novell The Last Question. Asimov föreställer sig en framtid där stark artificiell intelligens och posthumans konsumerar kosmos, under den tid vilken Kurzweil beskriver som universum vaknar upp - det sista av hans sex stadier av kosmisk evolution, beskriven i The Singularity is Near. Posthumanistiska varelser i olika tidsperioder av historien undersöker hur en entropisk död kan bli undviken. Den artificiella intelligensen svarar att den inte har tillräckligt med information för att komma med ett svar, ända tills i slutet av novellen då den faktiskt kommer med en lösning, och demonstrerar den genom att återskapa universum från scratch. Den gör detta för att leva upp till robotologins tre lagar för att svara på människornas fråga.

Eamonn Healy, kemist på St. Edward's University, pratar i filmen "Waking Life" om accelererande förändring. Han delar in historien i allt kortare tidsperioder; uppskattningsvis två miljarder år för livet, sex miljoner år för primater och ett hundra tusen år för mäniskligheten som vi känner till den. Han fortsätter sedan till den kulturella utvecklingen, med en tidskala på tiotusen år för agrikultur, fyrahundra år för den vetenskapliga revolutionen och etthundrafemtio år för den industriella revolutionen. Betoningen ligger på information som grund för det nya evolutionära paradigmet, varav artificiell intelligens är dess kulmination. Han sluter sig till att vi eventuellt kommer att skapa "neohumans", vilka kommer bemäktiga sig mänsklighetens nuvarande roll i den vetenskapliga och teknologiska utvecklingen och tillåta den exponentiella trenden av accelererande förändring att fortsätta bortom begränsningarna hos den mänskliga förmågan.

Accelererande utveckling är ett vanligt innehåll i science fiction och är det centrala temat i Charles Strosss Accelerando. Andra noterbara författare som behandlar singularitetsrelaterade frågor inkluderar Karl Schroeder, Greg Egan, Ken MacLeod, David Brin, Iain M. Banks, Neal Stephenson, Tony Ballantyne, Bruce Sterling, Dan Simmons, Damien Broderick, Fredric Brown, Jacek Dukaj, Nagaru Tanigawa och Cory Doctorow. Ett annat relevant arbete är Warren Ellis pågående serietidning newuniversal.

I avsnittet "The Turk i Terminator: The Sarah Connor Chronicles så nämner John Connor singulariteten. Terminator-franschisen är baserad på konceptet av en mänskligt skapat datorsystem som blir självmedvetet och bestämmer sig för att förstöra människan. Den når senare superintelligens.

I filmen Screamers, baserad på Philip K. Dicks novell Second Variety, så börjar människans eget skapade vapen att designa och montera sig själva. Självreplikerande maskiner (här "Screamers") anses oftast vara en betydande faktor i den "slutgiltiga fasen", nästan som en katalyst till den accelererande förändringen som leder till singulariteten. Intressant nog så utvecklas screamers till en nivå där de börjar döda varandra och en uttrycker till och med sin kärlek för mäniskan. Denna idé är vanlig i Dicks historier, där han går bortom det simplistiska "människa mot maskin"-scenariot i vilken våra skapelser anser oss vara ett hot.

Dokumentärfilmen Transcendent Man är baserad på Ray Kurzweil och hans bok The Singularity Is Near. Filmen dokumenterar hans strävan efter att blottlägga vad han tror är människans öde. En ny film som är baserad på hans bok The Singularity Is Near är i produktion och är planerad att släppas under 2009.

Externa länkar

Essäer

- Singularities and Nightmares: Extremes of Optimism and Pessimism About the Human Future av David Brin

- A Critical Discussion of Vinge’s Singularity Concept av Robin Hanson

- Is a singularity just around the corner? av Robin Hanson

- Brief History of Intellectual Discussion of Accelerating Change

- One Half of a Manifesto av Jaron Lanier — en kritik av "cybernetisk totalism".

- One Half of an Argument — Ray Kurzweils svar till Lanier

- Artificial Intelligence will Kill our Grandchildren

- Hardcore Dynamic: Living on the Brink of Singularity

Singularitetsprojekt

- The Singularity Institute for Artificial Intelligence

- The SSEC Machine Intelligence Project

- The Artificial General Intelligence Research Institute

Portaler och wikis

- KurzweilAI.net

- Acceleration Watch

- Accelerating Future

- The SL4 Wiki

- Singularity! A Tough Guide to the Rapture of the Nerds by Charles Stross

- Singularity Hub

Referenser

- ↑ 1,0 1,1 Singularity Institute for Artificial Intelligence (2002), Why Artificial Intelligence? Archive copy at the Internet Archive

- ↑ 2,0 2,1 Kurzweil, Raymond (2001), Lifeboat Foundation, The Law of Accelerating Returns, retrieved on 7 August 2007

- ↑ Good, I.J. (1965), Franz L. Alt and Morris Rubinoff, ed., "Speculations Concerning the First Ultraintelligent Machine", Advances in Computers (Academic Press) 6: 31-88, [1], retrieved on 7 August 2007

- ↑ Vinge, Vernor (30-31 March 1993), "The Coming Technological Singularity", Vision-21: Interdisciplinary Science & Engineering in the Era of CyberSpace, proceedings of a Symposium held at NASA Lewis Research Center (NASA Conference Publication CP-10129), retrieved on 7 August 2007

- ↑ Hanson, Robin (1998), Some Skepticism, retrieved on 7 August 2007

- ↑ 6,0 6,1 Berglas, Anthony (2008), Artificial Intelligence will Kill our Grandchildren, retrieved on 13 June 2008

- ↑ 7,0 7,1 Robin Hanson. ”Economics Of The Singularity”. IEEE Spectrum Special Report: The Singularity. http://www.spectrum.ieee.org/jun08/6274. Läst 2008-09-11.

- ↑ Engines of Creation (full text online, see also Engines of Creation) - Drexler, Eric K., Anchor Books, 1986

- ↑ Joy, Bill (April 2000), "Why the future doesn’t need us", Wired Magazine (8.04), retrieved on 7 August 2007

- ↑ Bostrom, Nick (2002), "Existential Risks", Journal of Evolution and Technology 9, retrieved on 7 August 2007

- ↑ Moravec, Hans (January 1992), On the Cosmology and Ecology of Cyberspace, Pigs in Cyberspace, retrieved on 21 November 2007

- ↑ Singularity Institute for Artificial Intelligence (2004), 3 Laws Unsafe, retrieved on 7 August 2007

- ↑ Ulam, Stanislaw (May 1958), "Tribute to John von Neumann", Bulletin of the American Mathematical Society 64 (nr 3, part 2): 1-49

- ↑ Hawkins, Gerald S. (August 1983), Mindsteps to the Cosmos, HarperCollins

- ↑ Kurzweil, Raymond (2005), The Singularity Is Near, New York: Viking, ISBN 0-670-03384-7

- ↑ Acceleration Studies Foundation (2007), ASF: About the Foundation, retrieved on 13 November 2007

- ↑ Zubrin, Robert, 1999, Entering Space - Creating a Spacefaring Civilization

- ↑ Dreyfus, Hubert L.; Dreyfus, Stuart E. (1 March 2000), Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer (1 ed.), New York: Free Press, ISBN 0743205510

- ↑ Stephen Hawking (1998), Science in the Next Millennium: Remarks by Stephen Hawking, retrieved on 13 November 2007

- ↑ John Smart (September 2005), On Huebner Innovation, Acceleration Studies Foundation, retrieved on 7 August 2007

- ↑ Joseph Tainter (1988) "The Collapse of Complex Societies" (Cambridge University Press) - en lag av "diminishing returns".

- ↑ Vernor Vinge (30-31 March 1993), "The Coming Technological Singularity", Vision-21: Interdisciplinary Science & Engineering in the Era of CyberSpace, proceedings of a Symposium held at NASA Lewis Research Center (NASA Conference Publication CP-10129), retrieved on 7 August 2007